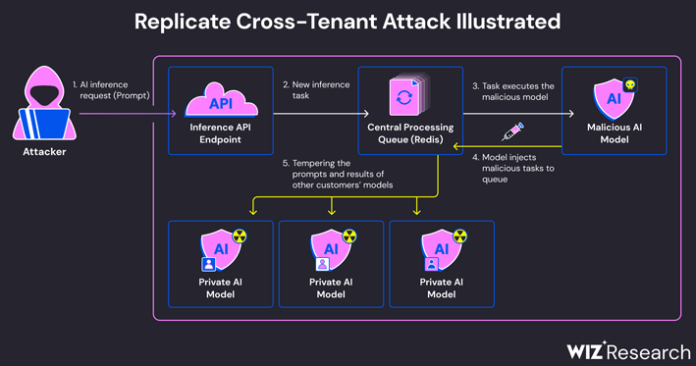

محققان امنیت سایبری یک نقص امنیتی مهم را در Replicate -ارائهدهنده خدمات هوش مصنوعی- کشف کردهاند که میتواند به عوامل تهدید اجازه دسترسی به مدلهای اختصاصی هوش مصنوعی و دادههای مشتریان را بدهد.

شرکت امنیت ابری Wiz در گزارشی که این هفته منتشر شد، گفت: «استفاده از این آسیبپذیری امکان دسترسی غیرمجاز به AI prompt ها و نتایج همه مشتریان پلتفرم Replicate را فراهم میکرد.

این مسئله از این واقعیت ناشی میشود که مدلهای هوش مصنوعی معمولاً در قالبهایی بستهبندی میشوند که امکان اجرای کد دلخواه را فراهم میکنند، که مهاجم میتواند با استفاده از یک مدل مخرب، از آنها برای انجام حملات cross-tenant استفاده کند.

Replicate از یک ابزار منبع باز به نام Cog برای کانتینرایز و بسته بندی مدلهای یادگیری ماشینی استفاده میکند که می توانند در یک محیط self-hosted یا Replicate مستقر شوند.

Wiz گفت که یک کانتینر Cog سرکش ایجاد و آن را در Replicate آپلود کرده و در نهایت از آن برای دستیابی به اجرای کد از راه دور در زیرساخت سرویس با امتیازات بالا استفاده می کند.

Shir Tamari و Sagi Tzadik، محققین امنیتی، میگویند: «ما گمان میکنیم این تکنیک اجرای کد یک الگو است، زمانی که شرکتها و سازمانها مدلهای هوش مصنوعی را از منابع غیرقابل اعتماد اجرا میکنند، با وجود این واقعیت که این مدلها کدهایی هستند که به طور بالقوه میتوانند مخرب باشند».

محققان میگویند: «یک مهاجم میتوانست مدلهای هوش مصنوعی خصوصی مشتریان را پرس و جو کند که به طور بالقوه دانش اختصاصی یا دادههای حساس مربوط به فرآیند آموزش مدل را در معرض دید قرار میدهد. علاوه بر این، رهگیری promptها میتواند دادههای حساس، از جمله اطلاعات شناسایی شخصی (PII) را در معرض نمایش بگذارد.

منبع: https://thehackernews.com/2024/05/experts-find-flaw-in-replicate-ai.html